近日,山东大学网络空间安全学院郭山清教授团队在人工智能安全的研究中取得重要成果,两篇论文被网络和系统安全领域四大顶级学术会议之一ieee s&p 2024和人工智能领域顶级学术会议aaai 2024录用,山东大学均是这两篇论文的第一作者单位和通讯作者单位。

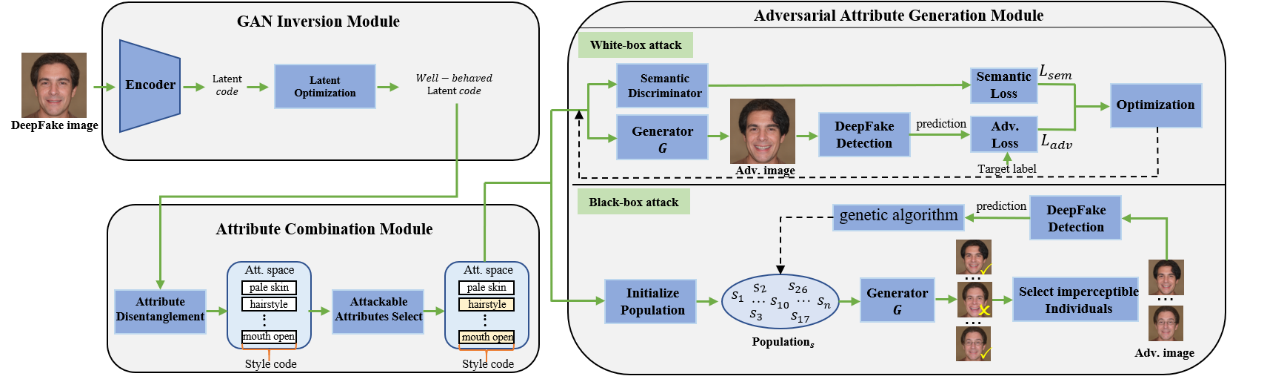

研究成果“ava: inconspicuous attribute variation-based adversarial attack bypassing deepfake detection”的第一作者是学院博士生孟祥涛,通讯作者为学院郭山清教授,香港城市大学助理教授赵晴川为主要合作者。深度伪造(deepfake)技术的滥用对个人以及社会构成了严重的隐私安全威胁,因此学术界和工业界提出了各种伪造检测算法来缓解其滥用。然而,当前的伪造检测算法容易受到恶意输入的欺骗,从而被攻击者轻松绕过检测。郭山清教授团队首次从语义扰动的角度提出了针对伪造检测算法的对抗攻击新方法(ava),构建不同威胁模型以及制定不同属性组合策略,对学术界和工业界的伪造检测算法的鲁棒性开展全面评估,揭示其潜在的安全风险。实验结果表明该方法在多个互联网厂商部署的伪造检测api上攻击成功率均在95%以上(已得到厂商的官方确认与致谢),对嵌入上述api的下游应用构成了巨大的安全威胁。该研究成果近日被网络和系统安全领域四大顶级学术会议之一ieee s&p 2024录用,填补了现有研究中对伪造检测模型安全风险探讨的不足,为高鲁棒伪造检测算法的设计提供了研究新思路。

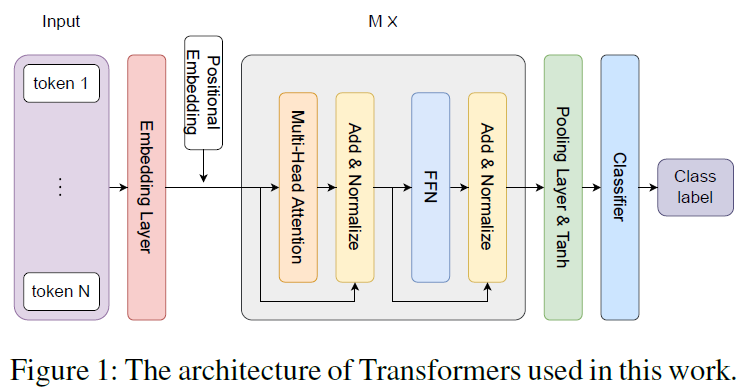

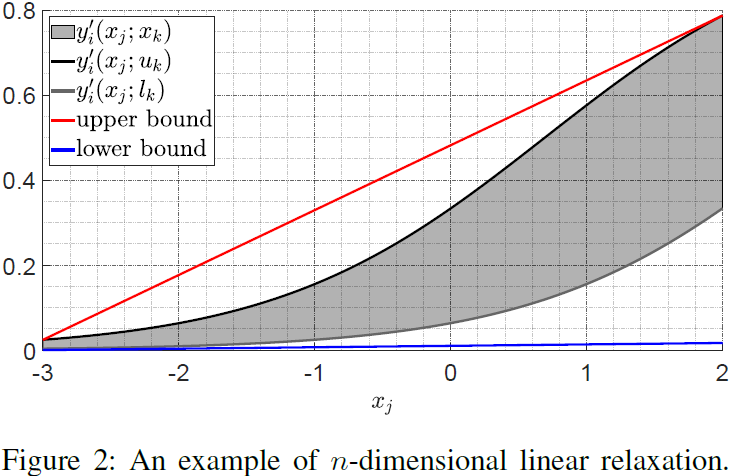

研究成果“galileo: general linear relaxation framework for tightening robustness certification of transformers”的第一作者是学院博士生张云若,通讯作者为学院郭山清教授。transformer模型是现今人工智能领域应用最广泛的模型之一,在自然语言处理和计算机视觉等任务上都取得了最先进的指标。然而,transformer模型对输入中的恶意微扰十分敏感,对其在高安全性领域的应用造成严重威胁。郭山清教授团队首次提出n维空间中非线性函数的线性放松技术,设计了一种新型transformer模型的鲁棒性验证方法,通过在常用数据集及多个具有不同大小的模型上的实验证明了此方法的计算结果优于对比方法,实现了transformer模型可信鲁棒半径的精确计算与度量,保障了基于transformer模型的人工智能应用的可靠性与安全性。该研究成果近日被人工智能领域顶级学术会议之一aaai 2024录用。

上述系列研究工作得到了国家自然科学基金、山东省重点研发计划等项目的资助。